©PaperWeekly 原创 · 作者 | 陈思硕

单位 | 北京大学

研究方向 | 自然语言处理

图片

当 LoRA 遇见 MoE,会擦出怎样的火花?

图片

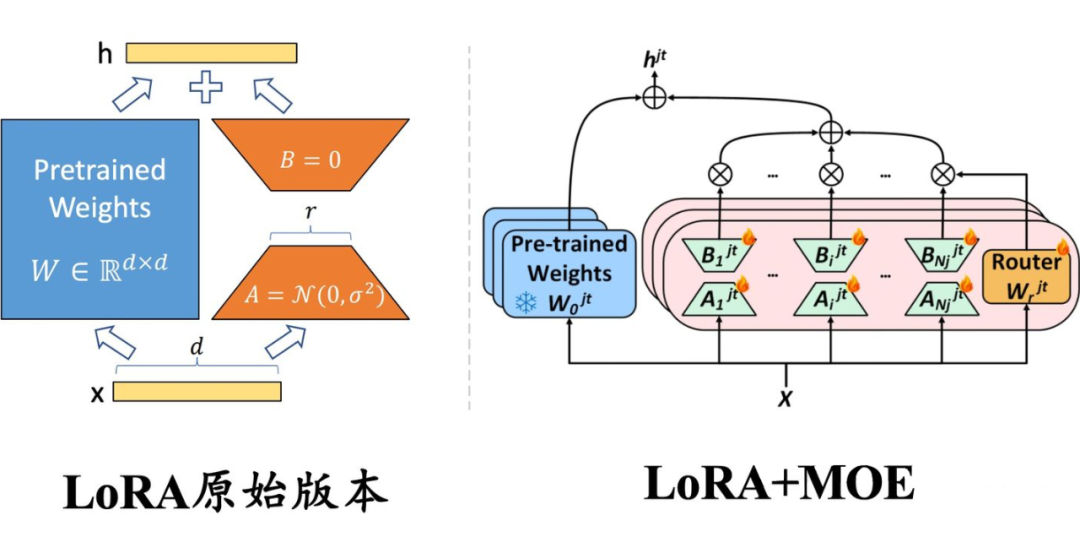

▲ 左侧:原始版本的 LoRA,权重是稠密的,每个样本都会激活所有参数;右侧:与混合专家(MoE)框架结合的 LoRA,每一层插入多个并行的 LoRA 权重(即 MoE 中的多个专家模型),路由模块(Router)输出每个专家的激活概率,以决定激活哪些 LoRA 模块。

传统上,LoRA 这类适配模块的参数和主干参数一样是稠密的,每个样本上的推理过程都需要用到所有的参数。近来,大模型研究者们为了克服稠密模型的参数效率瓶颈,开始关注以 Mistral、DeepSeek MoE 为代表的混合专家(Mixure of Experts,简称 MoE)模型框架。

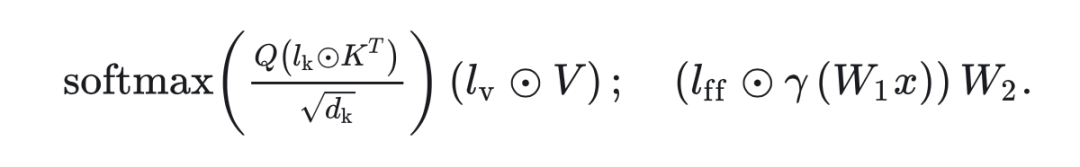

在该框架下,模型的某个模块(如 Transformer 的某个 FFN 层)会存在多组形状相同的权重(称为专家),另外有一个路由模块(Router)接受原始输入、输出各专家的激活权重,最终的输出为:

如果是软路由(soft routing),输出各专家输出的加权求和;

如果是离散路由(discrete routing),即 Mistral、DeepDeek MoE 采用的稀疏混合专家(Sparse MoE)架构,则将 Top-K(K 为固定的 超参数,即每次激活的专家个数,如 1 或 2)之外的权重置零,再加权求和。

在 MoE 架构中,每个专家参数的激活程度取决于数据决定的路由权重,使得各专家的参数能各自关注其所擅长的数据类型。在离散路由的情况下,路由权重在 TopK 之外的专家甚至不用计算,在保证总参数容量的前提下极大降低了推理的计算代价。

那么,对于已经发布的稠密大模型的 PEFT 训练,是否可以应用 MoE 的思路呢?近来,笔者关注到研究社区开始将以 LoRA 为代表的 PEFT 方法和 MoE 框架进行结合,提出了 MoV、MoLORA、LoRAMOE 和 MOLA 等新的 PEFT 方法,相比原始版本的 LORA 进一步提升了大模型微调的效率。

本文将解读其中三篇具有代表作的工作,以下是太长不看版:

LoRAMOE [2]:提出于 2023 年 12 月,在 MoLORA [1] 的基础上,为解决微调大模型时的灾难遗忘问题,将同一位置的 LoRA 专家分为两组,分别负责保存预训练权重中的世界知识和微调时学习的新任务,并为此目标设计了新的负载均衡 loss。

MOLA [3]:提出于 2024 年 2 月,使用离散路由(每次只激活路由权重 top-2 的专家),并发现在每一层设置同样的专家个数不是最优的,增加高层专家数目、降低底层专家数目,能在可训练参数量不变的前提下,明显提升 LLaMa-2 微调的效果。

图片

论文标题:

Pushing Mixture of Experts to the Limit: Extremely Parameter Efficient MoE for Instruction Tuning

论文链接:

https://arxiv.org/abs/2309.05444

图片

图片

▲ MOV 方法的示意图,引自论文[1]。

图片

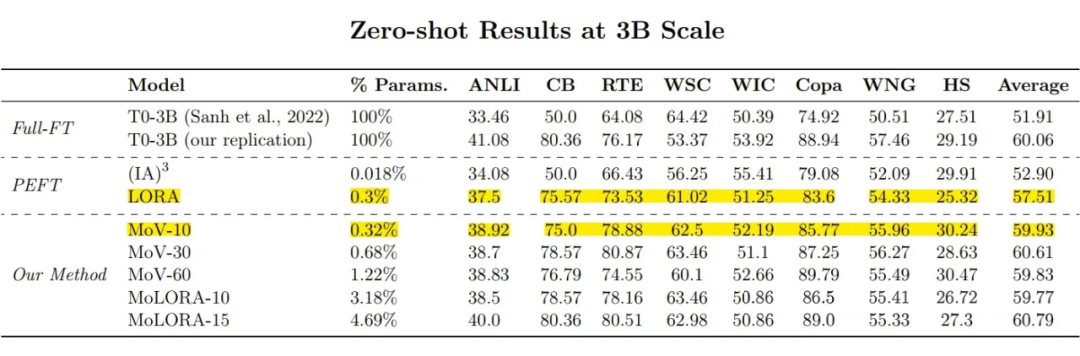

▲ 3B 模型的测试结果,只使用 0.32% 可训练参数的MoV-10 的平均 accuracy(59.93)接近全量微调(60.06),明显优于使用 0.3% 可训练参数的原始版本 LORA(57.71)。使用 0.68% 可训练参数的 MoV-30(60.61)甚至超过全量微调。

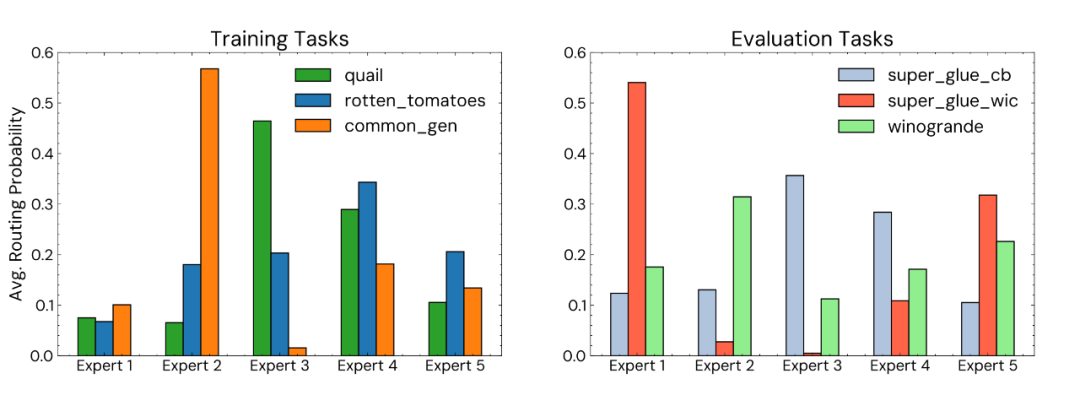

此外,作者还对专家的专门程度(speciality,即每个任务依赖少数几个特定专家的程度)进行了分析,展示 MOV-5 微调的 770M 模型最后一层 FFN 中各专家路由概率的分布:

图片

▲ 路由概率的分布,左侧为模型在训练集中见过的任务,右侧为测试集中模型未见过的任务。

可以看出,无论模型是否见过任务数据,大多数任务都有 1-2 个特别侧重的专家占据了大部分激活概率值,说明 MoV 这个 MoE 实现达成了专家的专门化。

图片

论文标题:

LoRAMoE: Revolutionizing Mixture of Experts for Maintaining World Knowledge in Language Model Alignment

论文链接:

https://arxiv.org/abs/2312.09979

此文为复旦大学 NLP 组的工作,研究动机是解决大模型微调过程中的灾难遗忘问题。

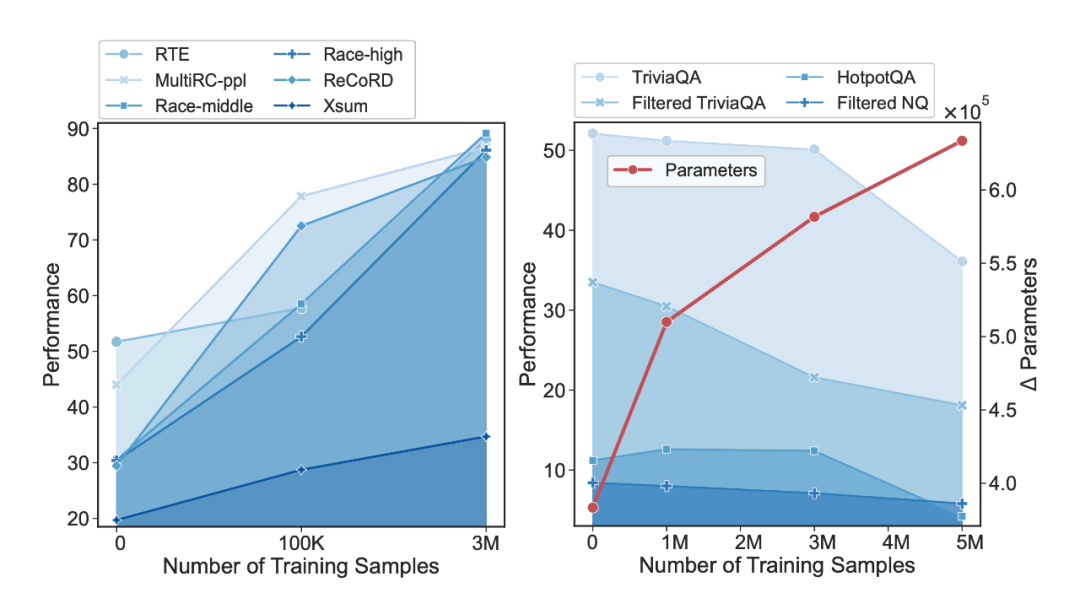

作者发现,随着所用数据量的增长,SFT 训练会导致模型参数大幅度偏离预训练参数,预训练阶段学习到的世界知识(world knowledge)逐渐被遗忘,虽然模型的指令跟随能力增强、在常见的测试集上性能增长,但需要这些世界知识的 QA 任务性能大幅度下降:

图片

▲ 左侧为不需要世界知识的常见测试集上的性能,右侧为需要世界知识的 QA 测试集上的表现,横轴为 SFT 数据量,红线为模型参数的变化程度。

作者提出的解决方案是:

数据部分:加入 world knowledge 的代表性数据集 CBQA,减缓模型对世界知识的遗忘;

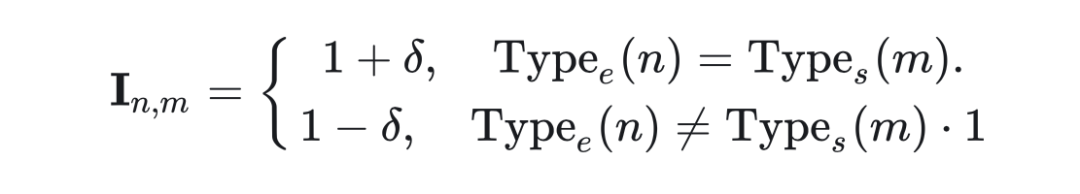

图片

图片

图片

这种“强者愈强”的极化现象是 MoE 领域的经典问题,可以参见经典的 sMoE 论文 The Sparsely-Gated Mixture-of-Experts Layer [4] 对该问题的阐述。

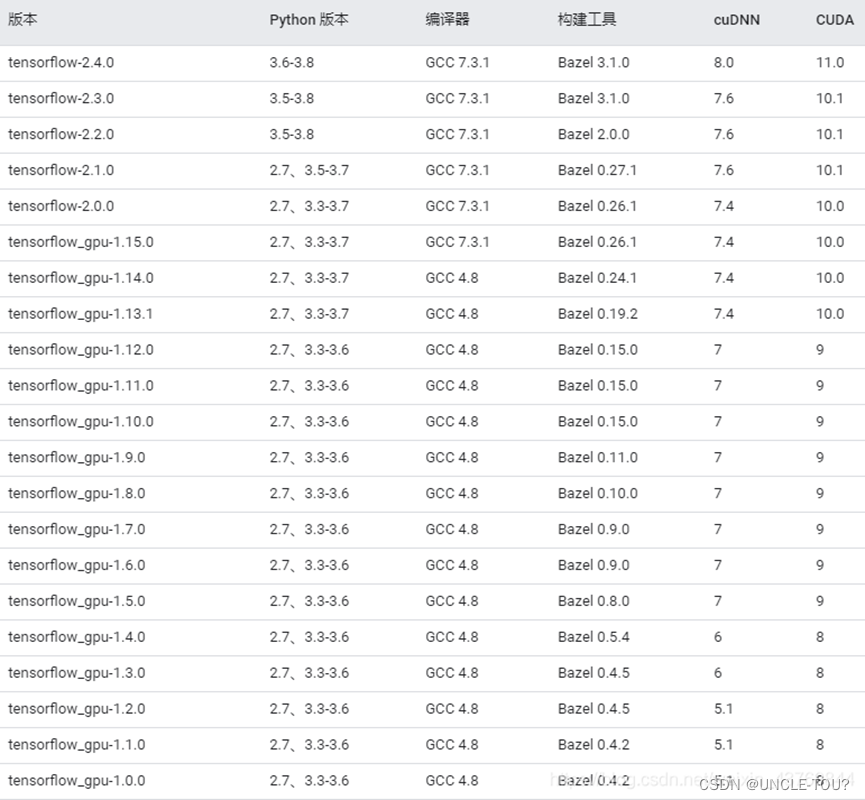

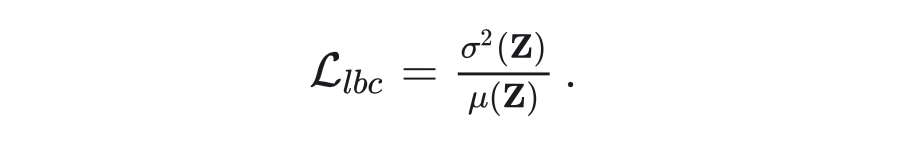

实验部分,作者在 CBQA 和一些列下游任务数据集混合而成的 SFT 数据上微调了 LLaMA-2-7B,对比了全量 SFT、普通 LORA 和作者所提的 LoRAMoE 的性能。

结果显示,LoRAMoE 有效克服了大模型 SFT 过程中的灾难性遗忘问题,在需要世界知识的 QA 任务(下表下半部分)上性能最佳,在与 SFT 训练数据关系更大的其他任务上平均来说基本与 SFT 训练的模型相当:

图片

图片

论文标题:

Higher Layers Need More LoRA Experts

论文链接:

https://arxiv.org/abs/2402.08562

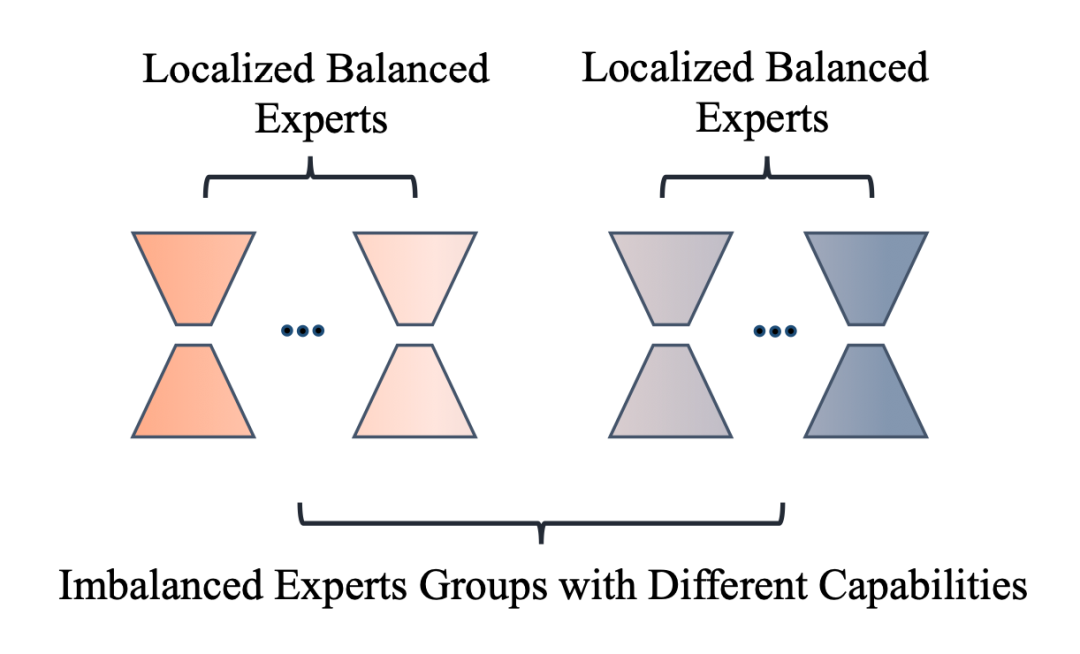

该工作受到 MoE 领域先前工作 [5] 发现的专家个数过多容易导致性能下降的现象之启发,提出了两个问题:

现有 PEFT+MoE 的微调方法是否存在专家冗余的问题?

如何在不同中间层之间分配专家个数?

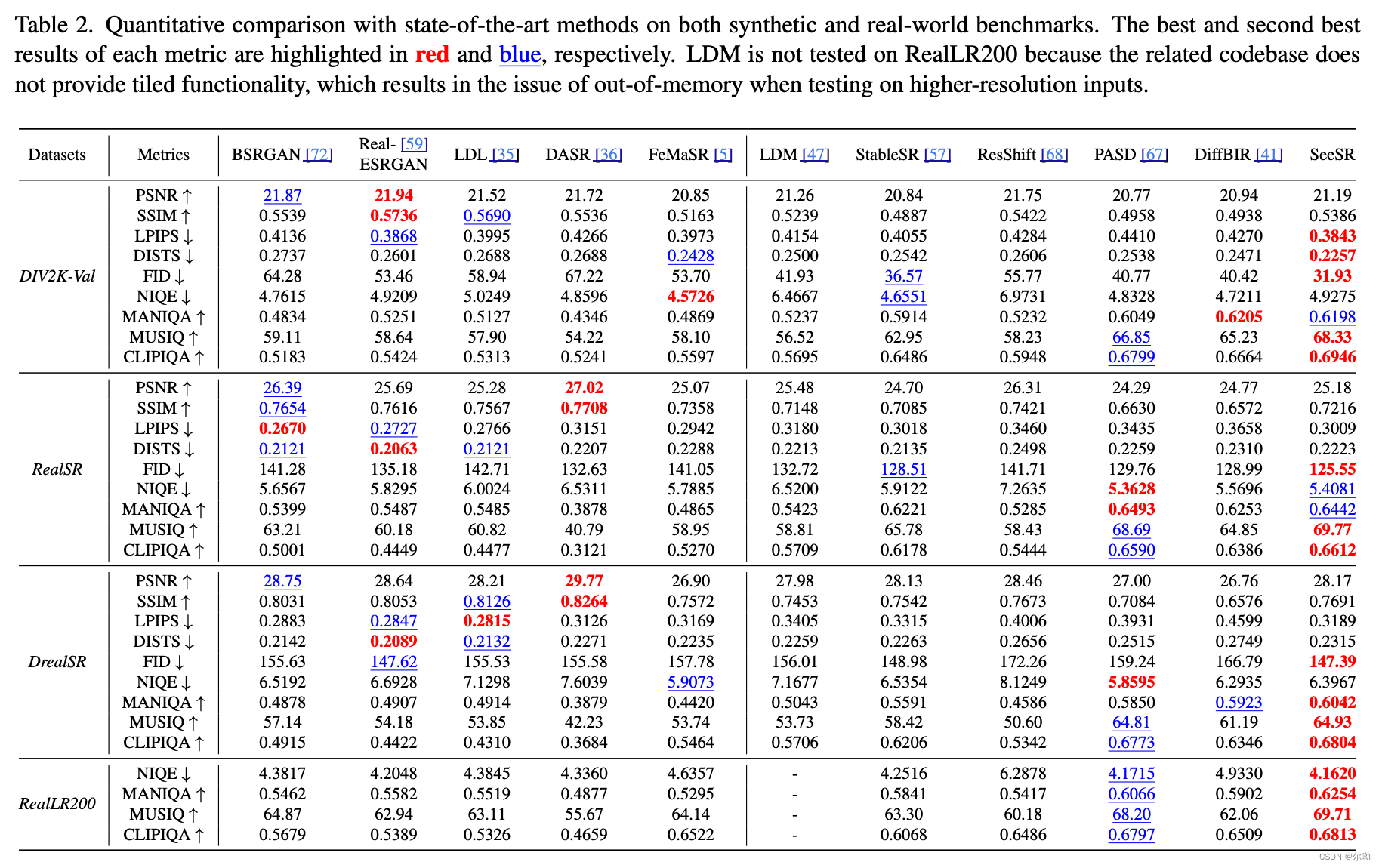

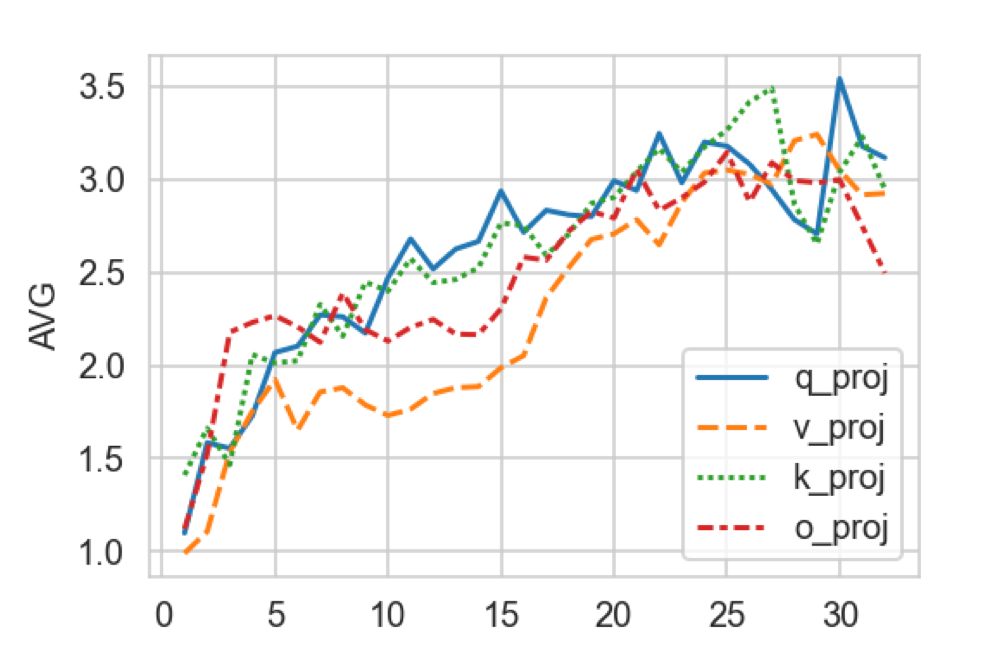

为了解答问题 1,作者训练了每层专家个数均为 5 的 LoRA+MoE(基座模型为 32 层的 LLaMa-2 7B),路由机制采用 Top-2 离散路由,计算了每层 self-attention 的 Q、K、V、O 各组专家权重内两两之间求差的 Frobenius 范数的平均值,可视化如下:

图片

▲ 横轴为模型层数,纵轴为专家权重之间的差异程度。

可以看出,层数越高(约接近输出端),专家之间的差异程度越大,而低层的专家之间差异程度非常小,大模型底层的 LoRA 专家权重存在冗余。该观察自然导出了对问题 2 答案的猜想:高层需要更多专家,在各层的专家个数之和固定的预算约束下,应该把底层的一部分专家挪到高层,用原文标题来说就是:

Higher Layers Need More Experts

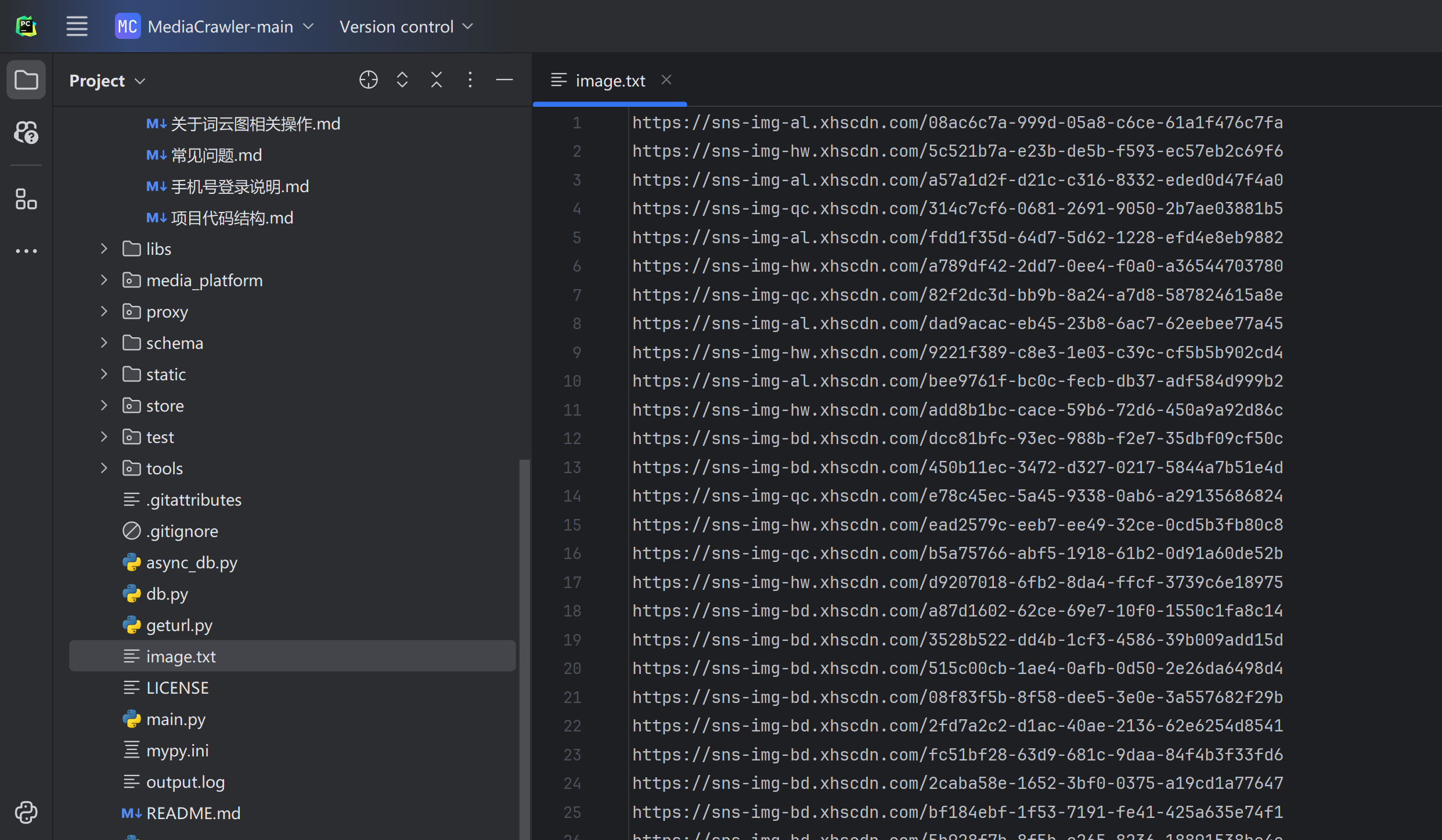

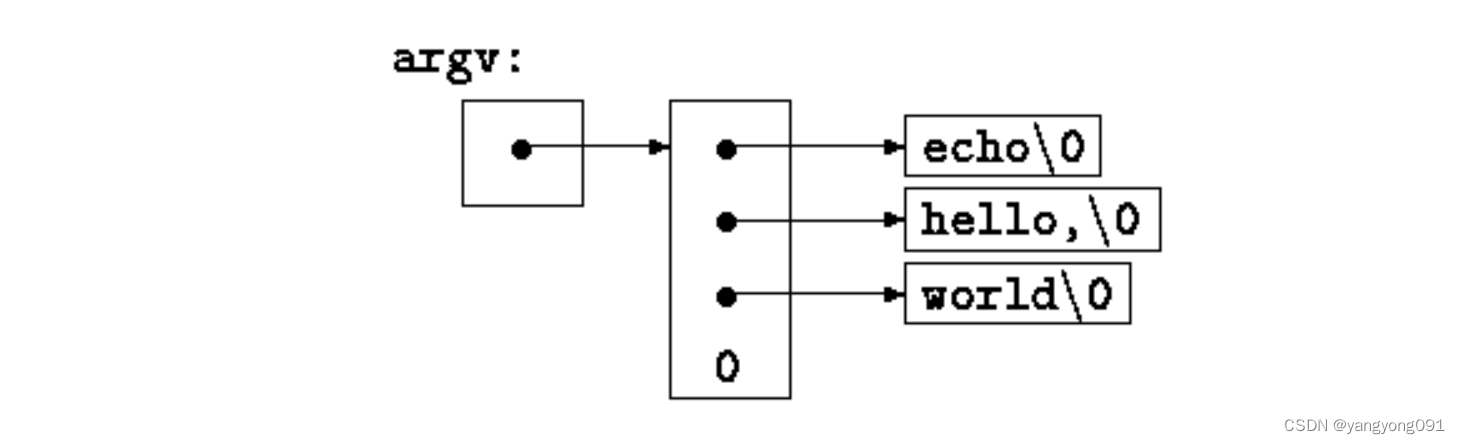

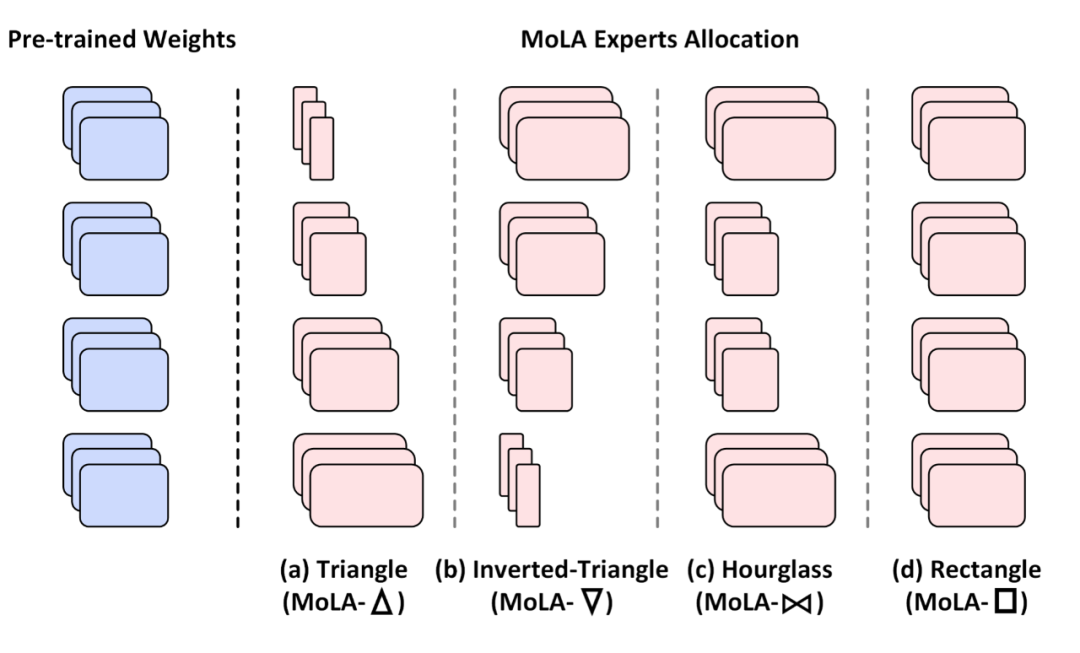

为了验证该猜想,作者提出了四个版本的专家个数划分方式分别严重性能,它们统称为 MoLA(MoE-LoRA with Layer-wise Expert Allocation),分别是:

MoLA-△:正三角形,底层专家个数多,高层专家个数少;

MoLA-▽:倒三角形,底层少,高层多;

MoLA-▷◁: 沙漏型,两头多、中间少;

MoLA-□:正方形,即默认的均匀分配。

图片

▲ 四种在不同中间层之间划分专家个数的方式。

具体实现中,作者将 LLaMA 的 32 层从低到高分为 4 组,分别是 1-8、9-16、17-24、25 到 32 层,以上四种划分方式总的专家个数相等,具体划分分别为:

MoLA-△:8-6-4-2

MoLA-▽:2-4-6-8;

MoLA-▷◁: 8-2-2-8;

MoLA-□:5-5-5-5。

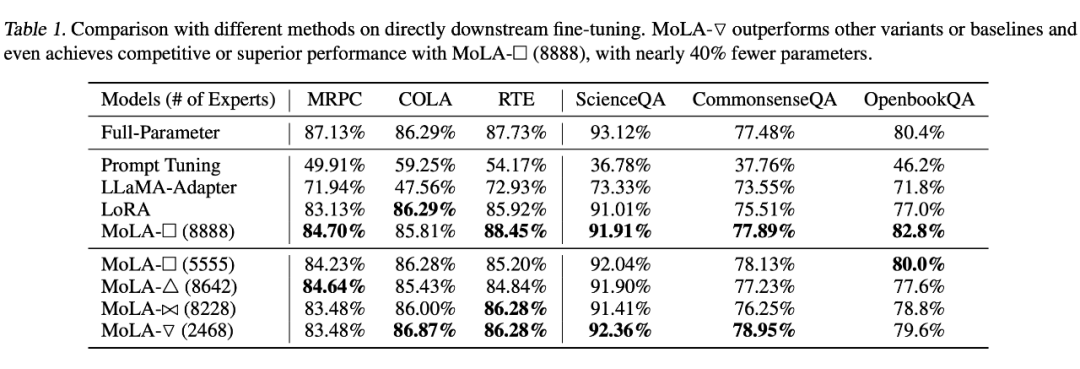

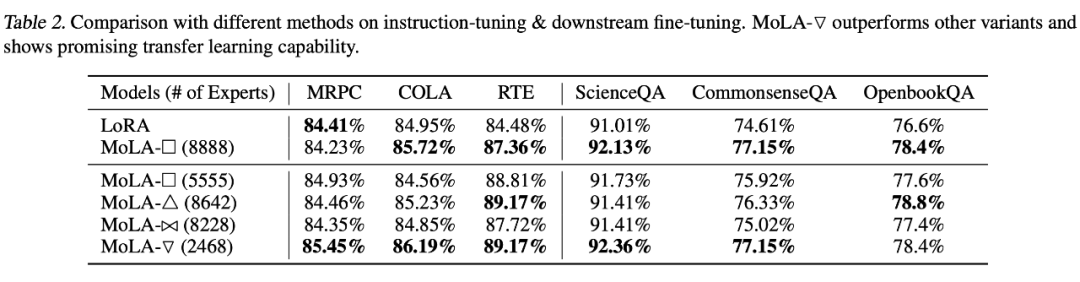

路由机制为 token 级别的 Top-2 路由,训练时加入了负载均衡损失。MoLA 的 LoRA rank=8,基线方法中 LoRA 的秩为 64(可训练参数量略大于上述四种 MoLA,与 MOLA-□ 的 8-8-8-8 版本相同)评测数据集为 MPRC、RTE、COLA、ScienceQA、CommenseQA 和 OenBookQA,在两种设定下训练模型:

设定1:直接在各数据集的训练集上分别微调模型;

设定2:先在 OpenOrac 指令跟随数据集上进行 SFT,再在各数据集的训练集上分别微调模型。

从以下实验结果可以看出,在设定 1 下,MoLA-▽ 都在大多数数据集上都取得了 PEFT 类型方法的最佳性能,远超可训练参数量更大的原始版本 LoRA 和 LLaMA-Adapter,相当接近全量微调的结果。

图片

▲ 设定1下的实验结果

在设定 2 下,也是倒三角形的专家个数分配方式 MoLA-▽ 最优,验证了“高层需要更多专家”的猜想。

图片

笔者点评:从直觉来看,模型的高层编码更 high-level 的信息,也和目标任务的训练信号更接近,和编码基础语言属性的底层参数相比需要更多调整,和此文的发现相符,也和迁移学习中常见的 layer-wise 学习率设定方式(顶层设定较高学习率,底层设定较低学习率)的思想不谋而合,未来可以探索二者的结合是否能带来进一步的提升。

图片

参考文献

[1] Zadouri, Ted, et al. "Pushing mixture of experts to the limit: Extremely parameter efficient moe for instruction tuning."arXiv preprint arXiv:2309.05444(2023).https://arxiv.org/pdf/2309.05444.pdf

[2] Dou, Shihan, et al. "Loramoe: Revolutionizing mixture of experts for maintaining world knowledge in language model alignment."arXiv preprint arXiv:2312.09979(2023).https://arxiv.org/abs/2312.09979

[3] Gao, Chongyang, et al. "Higher Layers Need More LoRA Experts."arXiv preprint arXiv:2402.08562(2024).https://arxiv.org/abs/2402.08562

[4] Shazeer, Noam, et al. "Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer."International Conference on Learning Representations. 2016.https://arxiv.org/abs/1701.06538

[5] Chen, Tianlong, et al. "Sparse MoE as the New Dropout: Scaling Dense and Self-Slimmable Transformers."The Eleventh International Conference on Learning Representations. 2022.https://arxiv.org/abs/2303.01610